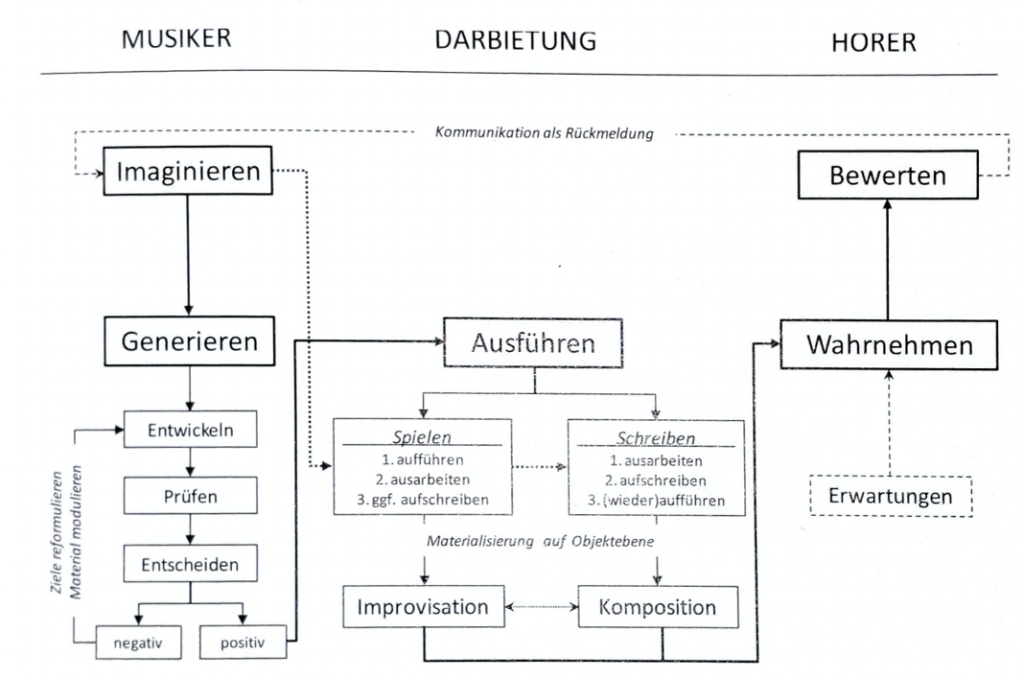

Die Komponisten können nach den Studien Pohjannoro’s (2016) Probleme in ihrem Produktionsprozess überwinden, indem bewusste Zielsetzungen und Ideen geschaffen werden, die vom Künstler selbst als Intuition empfunden werden. Danach kann er nach Evaluation des Stücks auch im Entscheidungsprozess zurückgehen, um seine Fehler zu verbessern, während er gleichzeitig schon das Endprodukt vor Augen hat. Es kommt jedoch nach Lothwesen & Lehmann (2018) immer auf das Verhalten der Einzelpersonen an, welches nicht unbedingt verallgemeinerbar ist, jedoch „wichtige Einsichten in die Individualität und Komplexität der generativen Tätigkeiten“ (Lothwesen & Lehmann (2018, S. 352) bringt. Bahle (1982, S. 84) machte außerdem deutlich, dass Komponieren umso unbewusster verläuft, je mehr die übernommenen Methoden durch häufiges Anwenden unter die Bewusstseinsschwelle versinken. Er schrieb außerdem:

„Je ausgeprägter und origineller ihr Personalstil ist, um so bewusster verläuft der Schaffensprozess, das heißt um so mehr findet man die Methoden des Experimentierens und Reflektieren in ihrem Gesamtschaffen, das dann einem Arbeitsprozess mit all seinen Stockungen und Mühen gleicht.“ – Bahle (1982, S. 84)

Außerdem ist ohne Übung weder Leistungssteigerung noch Leistungserhalt möglich, wobei mit Übung dabei eher die Wiederholung von Verhaltensweisen bezeichnet wird (Renkl, 2009, S. 19). Damit ist von Platz & Lehmann (2018, S. 75) unter anderem der Zuwachs von Erfahrung beschrieben. Bis 1980 nahm man laut Baer (2015) an, die kreativen musikalischen Fähigkeiten wären ein Persönlichkeitsmerkmal, wobei man heutzutage davon ausgeht, dass diese als domänenspezifisch trainierbar gelten. Bei diesen Theorien muss ein Individuum zunächst „Willen und Gelegenheit zur kreativen Beschäftigung mit Musik“ haben, sowie die nötigen Fertigkeiten zur Ausübung bereitstellen (Lothwesen, Lehmann (2018, S. 346). Angenommen wird auch, dass „kreative Problemlösungen nicht von der Expertise abhängen, die lediglich eine notwendige, aber keine hinreichende Voraussetzung darstellt“ (Lothwesen & Lehmann (2018, S. 346). Es gibt demnach auch unkreative Experten in ihren Domänen.

20

Nach Schneider‘s Serendipitätsprinzip (2006) werden manche Lösungen zufällig gefunden und einer passenden Fragestellung nachträglich zugeordnet. Dieses Prinzip passt auch zu den Erkenntnissen von Bahle (1982), wie bereits oben beschrieben, da sich auch das Experimentieren ohne Expertise in den Schaffensprozess eingliedern lässt, es jedoch womöglich von der Expertise abhängt, wie zielgerichtet das Experimentieren gelingt. Aus Sicht der Gehirnforschung gibt es laut Altenmüller (2006) unter anderem die Frontalhirnhypothese, welche besagt, dass „musikalische Kreativität mit einem gewissen Grad an Kontrollverlust einhergeht.“ (Lothwesen & Lehmann, 2016, S. 356; Altenmüller, 2006). Es wird dabei angenommen, dass bei zunehmenden kreativen Schaffensprozessen, wie Melodiebildung, die rechte tempoparietale Übergangsregion (rTPJ) deaktiviert wird, welche in Verbindung mit der Steuerung von Aufmerksamkeitsprozessen und sozialen Interaktionen gesehen wird. Dies kann das Generieren und Ausführen von kreativen musikalischen Handlungen unterstützen und ist Expertise-abhängig, also bei unerfahrenen Künstlern konnte kein solcher Effekt festgestellt werden (Lothwesen & Lehmann, 2016, S. 356; Altenmüller, 2006).

Altenmüller, E. (2006). Das improvisierende Gehirn. Musikpsychologie und Musikermedizin, 13(1), S. 1-10

Amabile, T. (1983). The social psychology of creativity: A componential conceptualisation. Journal of Personality and Social Psychology, 45(2), S. 357-376

Baer, J. (2015). Bridging generality and specifity. The amusement Park Theoretical model of creativity. Roeper Review, 27(3), S. 158-163

Bahle, J. (1947) Der musikalische Schaffensprozess: Psychologie der schöpferischen Erlebnis- und Antriebsformen. Konstanz: Christiani

Bahle, J. (1982). Eingebung und Tat im musikalischen Schaffen: Ein Beitrag zur Psychologie der Entwicklungs- und Schaffensgesetze schöpferischer Menschen (2., unveränd. Aufl.). Hemmenhofen/Bodensee: Kulturpsychologischer Verl. S. 84

Kaufmann, J.; Sternberg, R. (2010). The Cambridge handbook of creativity. Cambridge. CUP.

Lothwesen, K.; Lehmann, A. (2018). Komposition und Improvisation. In: Handbuch Musikpsychologie. Hogrefe S. 346ff

Platz, F.; Lehmann, A. (2018). Vom Anfänger zum Experten: Lernen, Übung, Motivation. In: Handbuch Musikpsychologie. Hogrefe S. 75

Pohjannoro, U. (2016). Capitalising on intuition and refelction: Making sense of a composer’s creative process. Musicae Scientiae, 20(2), S. 166-188

Renkl, A. (2009). Wissenserwerb. In: E. Wild & J. Möller (Hrsg.), Pädagogische Psychologie. (S. 3-26). Heidelberg. Springer

Schneider,M. (2006). Teflon, Post-it und Viagra: große Entdeckungen durch kleine Zufälle. Weinheim: Wiley-VCH.

Webster, P.R. (2002). Creative thinking in music: Administrative Guideline. Evanston. Northwestern University