Das Gedächtnis

Beim Gedächtnis lautet einer der zentralen Erkenntnisse, dass je öfter gelernt wird, desto schneller wird (dieselbe) Sache erlernt. Das heißt, je öfter eine Tätigkeit getan wird oder eine Information abgerufen wird, desto schneller und präziser ist sie verfügbar.

Man spricht in der Psychologie von einem Mehrspeichermodell, bei dem man von mehreren Gedächtnisarten ausgeht [1]. Wenn ein Reiz registriert wird, nimmt das sensorische Gedächtnis (Ultra-Kurzzeitgedächtnis) dies auf. Das sensorische Gedächtnis ist die Verbindung zwischen Wahrnehmung und Gedächtnis und läuft unbewusst ab. Es handelt sich teils um flüchtige Sinneseindrücke, die nur kurz zwischengespeichert werden. Es kommt im weiteren Schritt zur Filterung und Differenzierung der verschiedenen einwirkenden Reize. Die gefilterten Sinneseindrücke gelangen dann zum Arbeitsgedächtnis bzw. Kurzzeitgedächtnis. Dies ist der erste bewusste Teil unseres Gedächtnisses. Fünf bis neun Informationseinheiten können hier für eine kurze Zeit gespeichert werden. Für die Aufrechterhaltung solcher Information spielt die Aufmerksamkeit eine wichtige Rolle. Dies kann leicht durch Störungen, wie beispielsweise Geräusche, gestört werden. Werden Elemente aus dem Kurzzeitgedächtnis mit genug Aufmerksamkeit vollzogen oder oft genug wiederholt, kommt es zur Speicherung im Langzeitgedächtnis [4].

Die Reise vom Kurzzeitgedächtnis zum Langzeitgedächtnis (Konsolidierung)

Die Festigung von Gedächtnisinhalten wird Konsolidierung genannt und beschreibt die Bewegung von Kurzzeitinformation vom Hippocampus zum Cortex. Hier werden Gedächtnis-Engramme auf molekularer Ebene von Proteinen festgelegt [3]. Engramme sind Veränderungen des Nervengewebes zur Fixierung von Gelerntem. Es werden quasi „Bahnen“ in der Hirnstruktur gelegt, die später willkürlich oder unwillkürlich abrufbar sind und die physiologische Grundlage des Gedächtnisses bilden [2]. Dieser Vorgang findet nicht nur einmal bei der Einprägung statt, sondern immer wieder erneut, wenn die Erinnerung aus dem Langzeitgedächtnis abgerufen wird. Durch die erneute bzw. immer wieder auftretende Konsolidierung kann der Gedächtnisinhalt zwar gefestigt, jedoch auch verfälscht werden. Dies führt dazu, dass im Laufe der Jahre immer mehr Erinnerungen unbewusst abgewandelt werden. Ebenso sind neu gebildete Erinnerung anfälliger für Störungen und können leichter in Vergessenheit geraten [3].

Langzeitgedächtnistypen

Wenn es zu einer Speicherung im Langzeitgedächtnis kam, können diese Inhalte in verschiedene Kategorien unterteilt werden. Generell gibt es zwei Langzeitgedächtnistypen, nämlich das deklarative (explizite) und das prozedurale (implizite) Gedächtnis. Diese Typen sind in verschiedenen Gehirnarealen abgespeichert und dadurch physisch voneinander abgetrennt. Kommt es beispielsweise zu einer Beschädigung eines Gehirnareals, kann das betroffene Wissen nicht mehr abgerufen werden, während die anderen Inhalte problemlos genutzt werden können. Die zwei expliziten passieren bewusst, während die zwei impliziten Gedächtnistypen unbewusst passieren [5]:

- Episodisches Gedächtnis (explizit, bewusst):

Hier sind biografische Daten abgespeichert, wie beispielsweise die Erinnerung an einen Urlaub, Erlebnisse mit Freunden oder unseren ersten Schultag. - Semantisches Gedächtnis (explizit, bewusst):

Erlernte Fakten, wie beispielsweise „die Hauptstadt von Frankreich ist Paris“, die Geburtsdaten der Eltern, Vokabeln usw. - Prozedurales Gedächtnis (implizit, unbewusst):

Das Gedächtnis für Bewegungsabfolgen wie Laufen, Fahrradfahren, Autofahren usw. - Perzeptuelles Gedächtnis (implizit, unbewusst):

Dieser Gedächtnistyp ist eng mit dem Prozeduralen Gedächtnis verbunden. Es hilft uns bekannte Personen, Orte, Gegenstände wieder zu erkennen.

Das Gedächtnis ist eine subjektive Repräsentation der objektiven Welt. Es kommt schnell zu Abweichungen, Überschreibungen oder Störungen. Je nach Queue werden Inhalte verschieden abgerufen. So kommt es je nach Wording oder Kontext zu verschiedenen Ergebnissen und ist somit stark fehlerbehaften. Beispielsweise könnte man beim schnellen Hinsehen eine Maus mit einem Maulwurf verwechseln, wenn man zuvor einen Maulwurfshügel gesehen hat.

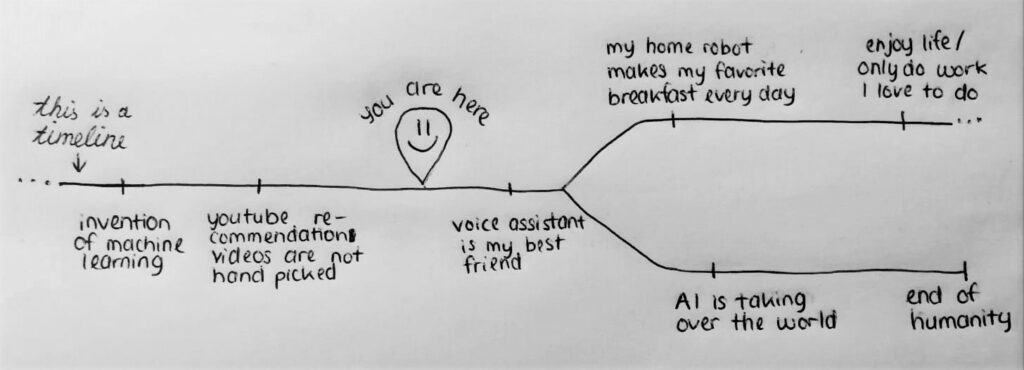

Mit dem Wissen, wie Information verarbeitet und abgespeichert wird, möchte ich Verständnis dafür erlangen, wie man Inhalte als Designer, von beispielsweise Lernanwendungen, gezielter vermitteln kann. Nachdem erarbeitet wurde, was im Gehirn grob passiert, wenn Dinge erlebt und erlernt werden, kann betrachtet werden, welche äußeren und inneren Gegebenheiten diesen Vorgang leichter in Gang setzen. Dies soll helfen um aus dem flüchtigen Bedienen einer Anwendung, eine langanhaltende Erinnerung bzw. Wissen zu formen.

Quellen

[1] Stangl, W.: Mehrspeichermodelle – Online Lexikon für Psychologie und Pädagogik, 27.07.2021

https://lexikon.stangl.eu/5117/mehrspeichermodelle

[2] Spektrum.de: Engramm – Lexikon der Neurowissenschaft, 19.04.2019

https://www.spektrum.de/lexikon/neurowissenschaft/engramm/3495

[3] Spektrum.de: Konsolidierung – Lexikon der Neurowissenschaft, 14.01.2019

https://www.spektrum.de/lexikon/neurowissenschaft/konsolidierung/6663

[4] Ratgeber Neuropsychologie: Einteilung des Gedächtnisses, 01.03.2018

https://www.ratgeber-neuropsychologie.de/gedaechtnis/gedaechtnis2.html

[5] Die Ebenen des Gedächtnisses, 30.07.2017

https://www.gehirnlernen.de/lernen/grundlagen-des-lernens/ebenen-des-ged%C3%A4chtnisses/