Hallo, Reisende. Ich bin Kris Giampa, Sound Supervisor für Diablo IV.

Das Soundteam arbeitet nun schon eine ganze Weile an der Klanglandschaft von Diablo IV. Zwar sind wir noch nicht bereit, die Musik des Spiels in aller Tiefe vorzustellen, jedoch wollten wir euch ein paar Einblicke in die Audioprozesse, Inhalte und Motivationen verleihen, die unsere Soundentwicklung bestimmen.

Bevor wir anfangen, wollten wir euch etwas zum Anhören geben, während ihr dieses Quartalsupdate lest. Genießt die verschneite, düstere und stürmische Atmosphäre der Zersplitterten Gipfel, während ihr euch auf die Reise begebt. https://www.youtube.com/embed/F0G4ECzssK8?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0

Sound und Musik sind für Spiele der unsichtbare Klebstoff, der die Narrative zusammenhält und euch an euren Charakter und dessen Aktionen im Spiel bindet. Die Entwicklung des Sounds für ein Spiel ist eine spannende künstlerische Herausforderung, die man nicht sehen, sondern nur hören kann. Jedoch könnt ihr auch im wahrsten Sinne spüren, wie der Schall euren Körper erfüllt – je nachdem, womit ihr den Sound abspielt. Es ist ein unglaubliches Medium, das beeinflussen kann, was ihr beim Spielen empfindet. Oft ist das sehr subtil, gelegentlich ist es übersteigert, aber der Sound ist immer da, um das Gameplay in jedem Augenblick zu unterstützen. Wir hoffen, dass euch dieser Einblick in die verschiedenen Aspekte der Klangwelt des Spiels gefällt. Euch erwartet noch viel mehr davon, wenn ihr endlich die Gelegenheit bekommt, selbst zu spielen!

Natürlich wollen wir auch, dass diejenigen von euch mit Hörbeeinträchtigungen Diablo IV ebenfalls genießen können. Deswegen arbeiten wir daran, die Spielerfahrung für Menschen mit Hör- oder Sehbeeinträchtigungen inklusiv zu gestalten. Es gibt verschiedene Features für Barrierefreiheit, denen wir uns in Zukunft an dieser Stelle ausführlicher widmen wollen.

Der Teufel steckt im Detail

Für die Klanglandschaften von Diablo IV haben wir die Tradition der befriedigenden Kampfsequenzen fortgeführt, die Atmosphäre weiter ausgebaut, um die offene Welt zu unterstützen, und uns in die düstere und blutige Stimmung vertieft. Zugleich haben wir uns bemüht, einen klareren und dennoch ausdrucksstarken Sound zu liefern, der sich dem Spielgeschehen dynamisch anpasst.

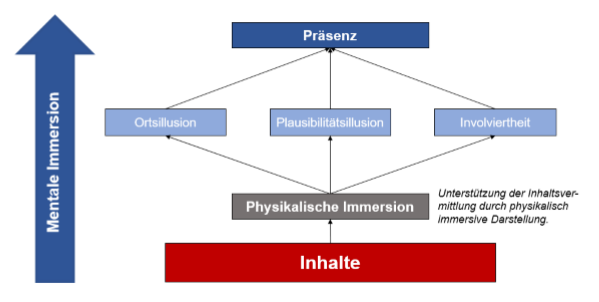

Eines unserer wichtigsten Ziele als Sounddesigner ist es, die qualitativ hochwertigsten Töne in Echtzeit im Spiel auszulösen und sie gemäß euren Erwartungen in der Welt verwurzelt und somit glaubwürdig erscheinen zu lassen. Wenn es ums Gameplay geht, hat die Zufälligkeit der Audiowiedergabe den allerhöchsten Stellenwert. Im echten Leben nimmt man keinen Ton zweimal auf exakt dieselbe Art und Weise wahr, weil sich die Hörumgebung oder die Positionierung der Quelle unterscheidet. Töne werden nie mit dem exakt gleichen Schalldruck erzeugt und durch Reflexionen in der Umgebung sowie alles andere, was in diesem Moment um euch herum geschieht, verzerrt. Kurz gesagt gibt es immer subtile, in der echten Welt verwurzelte Gründe, warum sich nichts jemals exakt gleich anhört. Das bedeutet, dass wir als Sounddesigner in einem Videospiel stets versuchen, subtile, zufällige Variationen hinzuzufügen – nicht nur dem Sounddesign an sich, sondern auch der Wiedergabe im Spiel. Wenn wir unsere Arbeit gut machen, ist das etwas, das ihr nicht bewusst bemerkt und das eure Immersion im Spiel unterstützt, indem die Grafiken, die Geschichte und die gesamte Erfahrung glaubhaft untermalt werden.

Ein weiteres wichtiges Ziel bei der Entwicklung des Sounds für Diablo IV ist die Erschaffung von Tönen für so ziemlich alles, was auf euren Bildschirmen passiert. Die Atmosphäre der Welt, Monster außerhalb des Bildschirms, die kleinen Holzsplitter, die von einer Wand abprallen, wenn ihr etwas kaputtmacht … alles sollte ein Geräusch machen. Wir investieren zahllose Stunden an Arbeit, um fast alles zu vertonen, was ihr seht oder auch nicht seht – und das gleichzeitig subtil genug, dass es nicht ablenkt, sondern sich genau richtig anfühlt. Hier steckt der Teufel definitiv im Detail …

Aber nur, weil wir so ziemlich alles vertonen, bedeutet das nicht, dass ihr diese Töne auch jedes Mal hören müsst. Basierend auf strikten Einstellungen, die wir als Grundregeln festlegen, löst die Playback Engine im Spiel nur eine begrenzte Zahl an Instanzen eines Tons aus, wenn diese alle gleichzeitig abgespielt werden müssten. Aufgrund der isometrischen Kameraperspektive und der Tatsache, dass so vieles gleichzeitig auf dem Bildschirm erscheint, müssen wir einschränken, wie viele Instanzen eines Tons zu einem bestimmten Zeitpunkt abgespielt werden. Mit der richtigen Abstimmung fällt gar nicht auf, dass einige Instanzen gar nicht ausgelöst werden. Das trägt zu einem klareren Sound bei. Es ist ein schmaler Grat, den wir in den epischen Momenten, in denen jede Menge auf dem Bildschirm passiert, genau treffen müssen.

Kommen wir jetzt zu den kreativen Aspekten des Sounddesigns. Natürlich gibt es kein Diablo-Spiel ohne die Helden, die unter eurem Befehl die verschiedenen Übel bezwingen, die sich euch in den Weg stellen. Sprechen wir über einige Feuerfertigkeiten des Zauberers, die zum Kern dieser Klasse gehören …

Helden-Feuerfertigkeiten

Das Soundteam hat das große Glück, alle möglichen spannenden und einzigartigen Töne für das Spiel aufnehmen zu können. So haben wir eine große Vielfalt an Ausgangsmaterial, das wir bearbeiten können, wenn es ans Sounddesign geht. Technisch beschrieben ist Sounddesign der Prozess, Tonaufnahmen zu bearbeiten und zur Verwendung in einem anderen Medium weiterzuverarbeiten. Beim Sounddesign für Videospiele fertigen wir Rohaufnahmen an, bereiten sie auf und bearbeiten sie auf unterschiedliche Arten, um sie unseren Gameplay-Bedürfnissen anzupassen und ein klares, wiederholbares Audio für das Spiel zu schaffen. Manche Töne werden genau so verwendet, wie wir ursprünglich beabsichtigt hatten, während andere am Ende völlig anders klingen an einer völlig anderen Stelle zum Einsatz kommen.

Eine Sache, die wir für ein Spiel wie Diablo wirklich immer brauchen, ist natürlich Feuer! Wenn die Zeit es zulässt, planen wir immer einige Aufnahmesessions im freien Feld. Eine der ersten großen Aufnahmen, die wir als Team für Diablo IV angefertigt haben, war eine Feuersession in der Wüste vor dem COVID-19-Lockdown. Mit einem Arsenal an Aufnahmeausrüstung und Mikrofonen sind wir weit vom Blizzard-Hauptquartier fortgereist, um verschiedene Arten von Feuergeräuschen in der Wüste Kaliforniens aufzunehmen. Zum Glück war es bereits Winter und deshalb tagsüber nicht zu heiß und nachts bloß ein wenig kühl. Auch wenn es uns hauptsächlich um Feuer ging, haben wir letztendlich auch alle möglichen anderen Geräusche aufgenommen, die wir in der Produktionsphase genutzt haben: Umgebungsgeräusche, Aufprall von Steinen, Laubrascheln, Aufprall von Holz, Türenschmettern, das Knarzen einer Holzhütte, Aufprallgeräusche von Metall und Kratzgeräusche.

Zaubererfertigkeiten

Feuerblitz und Inferno

Ein paar der aufgenommenen Feuergeräusche wurden dann für die Zaubererfertigkeiten Feuerblitz und Inferno genutzt. Für die Fertigkeit Feuerblitz haben wir sanft schwelendes Feuerzischen aufgenommen, indem das Geräusch auf verschiedene Arten mit einem Feuerstab oder einem mittelgroßen, trockenen Holzscheit erzeugt und mit Sets von Mikrofonen aufgefangen haben. Sobald wir eine gute Auswahl an verschiedenen Feuergeräuschen hatten, haben wir dieses Feuerzischen editiert und bearbeitet, um es im Spiel als einmalige Audiodateien für Wirk- und Aufprallgeräusche oder als längere Soundschleifen für den Flug des Projektils zu nutzen. Wenn das Ganze dann im Spiel als Soundeffekt der Fertigkeit Feuerblitz wiedergegeben wird, erhält man ein zusammenhängendes Klangerlebnis.

Für die Zaubererfertigkeit Inferno haben wir dann andere Ausschnitte der Feueraufnahmen genommen und sie für die größere Fertigkeit so bearbeitet, dass sie aggressiver und mächtiger klingen. Wie beim Feuerblitz gibt es ein Set von Einzelgeräuschen für das Wirken, ein Set von Soundschleifen und ein weiteres Set von Einzelgeräuschen beim Zusammenziehen der Schlangenform. Es ist ziemlich cool, dass die Fertigkeit Inferno nicht einfach nur aus Feuer besteht, sondern aus Feuer in Form einer Schlange. Wegen dieser Form haben wir ein paar Freiheiten und können mehr als nur Feuer-Sounddesign nutzen. Wir haben das Fertigkeitsgeräusch mit leichten Schlangenrasseln-Spezialeffekten unterlegt, und der Ton wird zum Ende hin düsterer und ätherischer, damit es sich etwas magischer anfühlt. Wenn all diese Elemente im Spiel ausgelöst werden, wird es sich immer wie dieselbe Fertigkeit anhören, aber jedes Mal etwas anders klingen. So erhöht der Sound den Wiederspielwert. https://www.youtube.com/embed/oaU4f6mzppU?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0

Sounddesign bei Monstern

Diablo-Spiele würden nicht so viel Spaß machen, wenn man keine Monster abschlachten könnte. Die Horden der verschiedensten Kreaturen sind einer der spaßigsten Aspekte, wenn man an einem Diablo-Spiel arbeitet. Deshalb sind Monster sowohl für experimentelles als auch für traditionelles Sounddesign perfekt geeignet. Schauen wir uns also das Sounddesign bei den Geräuschen und Stimmen der Monster an.

Monsterbewegungen

Die Mischung aus erstklassiger Animation und K.I. erfüllt die Kreaturen mit Leben und Persönlichkeit, wenn sie sich ihrer niederträchtigen Machenschaften hingeben. Zu Beginn der Audiobearbeitung für ein brandneues Monster empfehle ich den Sounddesignern immer, zuerst die Bewegungsanimationen mit Tritt- und sonstigen Bewegungsgeräuschen (wie Kleidung und Haut) zu unterlegen. Sobald eine Kreatur Tritt- und Bewegungsgeräusche hat, erwacht der Rhythmus ihrer Bewegung erst richtig zum Leben. Ab diesem Punkt sind sie meiner Meinung nach geerdet und mit der Welt verbunden. Das gibt auch vor, wie laut sie basierend auf ihrer Bewegungsmuster sein können.

Monsterstimme

Die nächste Ebene, die Kreaturen zum Leben erweckt, ist ihre Stimme. Dabei handelt es sich um das Grunzen und Brüllen, das sie ausstoßen, wenn sie den Spieler angreifen – oder die Schmerzensschreie, wenn ihr sie nacheinander ausschaltet. Die Monsterfamilien können sich ziemlich voneinander unterscheiden. Also haben wir je nach Monstertyp intensive Klangschichten von animalischen Geräuschen oder nutzen sogar alltägliche Objekte, um Geräusche zu erzeugen, die wie Kreischen oder Schreie klingen und eine zusätzliche Ebene der fertigen Stimme bilden. Manchmal engagieren wir auch einfach Kreaturen-Synchronsprecher an. Sie erschaffen den Kern der Monsterstimme, und wir können mit weiteren Geräuschen darauf aufbauen.

Das Sounddesign vom Waldwesen besteht fast komplett aus knarrendem und ächzendem Holz, dessen Geräusche wir extrem langgezogen haben, und der richtigen Auswahl an Tönen, um Emotionen zu vermitteln. Es hat viel Spaß gemacht, das Sounddesign vom Waldwesen zu entwerfen, da es größtenteils aus seltsamen, knarrenden Holzgeräuschen besteht, unterlegt von sehr tiefen menschlichen Tönen. https://www.youtube.com/embed/c8CS_6RLaZA?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0

Ein weiteres Monster, an dem wir gerne gearbeitet haben, war der abartig großartige Fliegenwirt. Diese Bestie gebiert laufend Fliegen, die den Spieler angreifen. Am Ende haben wir ein paar unserer frühen Aufnahmen von Metzelgeräuschen genommen. Dafür hatten wir Kohlköpfe und Melonen zerrissen und zerschlagen und außerdem Mayonnaise, Salsa und einen köstlichen Schicht-Dip zu einer nicht so toll riechenden Pampe vermatscht, um ein paar ekelhafte und schleimige Geräusche für unser Sounddesign zu erzeugen. https://www.youtube.com/embed/WvXKYrbOBlQ?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0

Umgebungsgeräusche der offenen Welt

Ein grundlegendes Prinzip beim Sound von Diablo IV ist „lebendiges Audio“. Das bedeutet, dass die Klanglandschaft sich stets entwickelt und niemals statisch bleibt. Dieses Prinzip ist tief in den verschiedenen Variationen der Sounddesigns verwurzelt, die wir für alle möglichen Klänge kreieren. Das gilt auch für die Echtzeitwiedergabe im Spiel, insbesondere bei der Umgebung. Da die riesige offene Welt eine zentrale Rolle spielt, wollten wir die Umgebungsgeräusche so detailliert wie möglich machen. Wir finden sie ebenso wichtig wie das Sounddesign der Helden. Für dieses Prinzip ist es wichtig, dass sich die Geräusche und Systeme mit der Zeit subtil verändern. Wir arbeiten immer darauf hin, dass die subtilen Veränderungen der Umgebungsgeräusche (die man womöglich kaum bemerkt) sich selten wiederholen und insgesamt natürlicher und immersiver anfühlen.

Das World Building-Team hat großartige Arbeit dabei geleistet, die Regionen optisch zu füllen und uns somit tonnenweise Inspiration für immersiven Umgebungsgeräusche zu geben.

Da Spieler sich womöglich sehr lange in der offenen Welt aufhalten, wollten wir jeder Außenregion eine einzigartige Klangumgebung schenken, in der es mit der Zeit auch subtile Veränderungen der Geräusche gibt. Um das zu erreichen, nutzen wir Audiosysteme wie Echtzeit-Okklusion, hochwertige Halleffekte und Verzögerungseffekte/Echos, die auf die Umgebung reagieren.

Hier zeigen wir euch ein paar längere Aufnahmen aus dem Spiel mit einem statischen Ausschnitt, damit ihr hören könnt, wie die Umgebungsgeräusche sich mit der Zeit verändern. Damit wollen wir euch nicht nur cooles Sounddesign für die Umgebung zeigen, sondern euch diese Aufnahmen auch für Pen-&-Paper-Sessions zur Verfügung stellen – oder einfach zur Untermalung, wenn ihr euch in eure Arbeit vertieft. Diese Ausschnitte bestehen aus Aufnahmen von 5–6 Minuten, die mit Soundschleifen fast eine Stunde dauern. https://www.youtube.com/embed/0RDwMOxZqsY?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0 https://www.youtube.com/embed/wnez77GvFpU?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0 https://www.youtube.com/embed/JRdkkd4BdYg?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0

Umgebungsgeräusche der Dungeons

Um die richtige Atmosphäre beim Metzeln in den Dungeons von Diablo zu erzeugen, ist es uns ein besonderes Vergnügen, verschiedene und einzigartige Klangerlebnisse zu erschaffen, damit ihr komplett in die Spielwelt eintauchen könnt. Im Vergleich zur neuen offenen Welt sind die Umgebungsgeräusche der Dungeons etwas weniger intensiv, da wir euch nicht von einer der spaßigsten Aktivitäten von Diablo ablenken wollen: Dungeons erkunden. Das ist ein Gebiet, das uns mehr Freiheiten erlaubt, um tief in die höllischen und gruseligen Klangwelten einzutauchen, während die Monster auf dem Bildschirm das Klangerlebnis begleiten. Für Diablo IV gehen wir es in Dungeons mit dem Grundsatz „Was ihr hört, bekommt ihr auch.“ etwas realistischer an. Mit langgezogenen Halleffekten und Geräuschokklusion wollen wir eure Aufmerksamkeit darauf lenken, was hinter der nächsten Ecke lauern könnte, und euch mental auf die nächste Ladung an Feinden vorbereiten.

Zerstörbare Objekte

In den Dungeons sind zahlreiche zerstörbare Objekte verstreut. Das Interactives-Team hat für Diablo IV hunderte unglaublich detaillierte zerstörbare Objekte geschaffen. Um dem Detailreichtum bei ihrer Zerstörung Rechnung zu tragen, wollten wir jeden einzelnen Splitter und Brocken mit glaubwürdigem physikalischen Audio versehen. In Diablo Objekte zu zerstören, sollte genau so glaubwürdig und befriedigend klingen, wie Monster zu töten. Wir haben uns viel Mühe gegeben, allen Objekten ein extrem befriedigendes Zerstörungsgeräusch zu verpassen. Zugleich erhalten die Trümmer winzige Töne, die die Einzelteile begleiten, wenn sie abbrechen und durch den Raum fliegen. Ich bin immer noch beeindruckt von den ganzen Details, die wir bei zerstörbaren Objekten in Diablo IV haben. Wenn ich einen Raum voll mit solchen Objekten sehe, liebe ich es, einfach drauf los zu schlagen! https://www.youtube.com/embed/xdjU8sAG-Vc?theme=light&color=white&cc_load_policy=1&HD=1&rel=0&showinfo=0

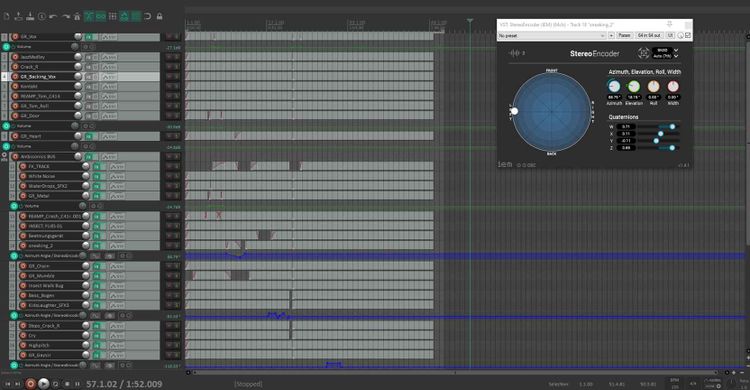

Mischung im Spiel

Zu guter Letzt möchte ich ein wenig über die isometrische Kamera sprechen. Sie stellt einen vor interessante Herausforderungen, wenn man alle Elemente des Spiels zusammenbringen will. Da man das Schlachtfeld aus einem bestimmten Winkel und aus einer bestimmten Entfernung betrachtet, müssen wir dafür sorgen, dass die Monster auf dem Bildschirm Geräusche von sich geben, ohne dass die Gesamtmischung insgesamt zu überladen oder zu leer klingt. Unter Berücksichtigung der Prioritäten der Spieler gibt es viel Hin und Her bei der Klangwiedergabe in Echtzeit.

Für Diablo IV können wir die Soundmischung in Echtzeit mehr lenken als je zuvor. Aufgrund der isometrischen Kameraansicht muss alles, das ihr seht, Geräusche erzeugen. Aber wir wollen auch, dass ihr euch auf die wichtigsten Geräusche konzentriert, die eure Aufmerksamkeit verlangen. Wir feilen an Audiomischungen und einem System, das den Fokus auf die wesentlichen Töne lenkt, damit die wichtigsten Monstergeräusche hervorstechen, wenn es nötig ist. Es ist schwer, eine klare Audiomischung zustande zu bringen, wenn es im Spiel mehrere Helden und viele verschiedene Monster auf dem Bildschirm gibt. Da wir zugleich detaillierte Hintergrundklänge haben, müssen wir je nach Situation verschiedene Audiomischungen kreieren.

Wir hoffen, dass euch dieser kleine Einblick in das Sounddesign von Diablo IV gefallen hat. Es gibt noch so viel mehr zu erzählen, aber leider müssen wir das auf ein anderes Mal verschieben. Wir freuen uns über jegliches Feedback zu allem, was ihr in den Videos gehört oder in diesem Quartalsupdate gelernt habt. Danke, dass ihr euch die Zeit genommen habt, um mehr über die Klanglandschaft von Diablo IV zu erfahren!

Kris Giampa,

Sound Supervisor, Diablo IV

Morrison Planetarium

Morrison Planetarium Planetarium Wenus

Planetarium Wenus IX Symposium

IX Symposium