Begriffsdefinitionen

Videospiele sind ein interaktive Medien, die einen interaktiven bzw. adaptiven Soundtrack erfordern. Tatsächlich muss aber zwischen interaktiver und adaptiver Musik unterschieden werden. Diese werden zwar oft in einen Topf geworfen, aber sie sollten dennoch unterschieden werden, weil sie genau genommen zwei unterschiedliche Dinge meinen. Der Komponist Michael Sweet spricht von interaktiver Musik, wenn der Spieler mit spielerischen Handlungen direkt die Musik beeinflussen kann, wie beispielsweise in Spielen wie Guitar Hero [1]. Adaptive Musik hingegen umfasst Musik, bei welchen der Spieler eine indirekte Kontrolle über die Musik hat. Diese reagiert, statt auf Tastenbefehle und anderen Eingaben des Spielers, auf Faktoren der Spielwelt wie Tageszeit, Wetter, Grad der Bedrohung, Spannungsintensität usw. David Vink schreibt, dass Musik adaptiv ist, wenn sie sich an Umweltbedingungen im Spiel anpasst [2]. Interaktive Musik hingegen wird durch den Spieler direkt ausgelöst. In diesem Artikel beziehe ich mich auf Methoden der adaptiven Musikgestaltung.

Adaptive Soundtracks werden, wenn sie mit Filmsoundtracks verglichen werden, auch als nicht-lineare Soundtracks bezeichnet. Filmmusik hingegen ist linear, da die Abfolge auf einer linearen Zeitachse stattfindet. In Videospielen ist die Abfolge der Handlung abhängig davon, wie und wann ein Spieler Aktionen durchführt. Dementsprechend muss der Sound auch die Fähigkeit besitzen sich an die Aktionen des Spielers anzupassen. [3, 4]

Wieso soll ein Soundtrack adaptiv sein?

Adaptive Soundtracks sind also Musikstücke, die auf verschiedene Umstände im Spiel reagieren. Nun stellt sich die Frage, wieso sollte ein Soundtrack überhaupt adaptiv sein? David Vink spricht davon, dass adaptiver Sound eine größere Wirkung auf den Spieler hat und gleichzeitig als Kommunikationsmittel dient. Beispielsweise, kann der Wechsel zu einem sehr rhythmischen Stück symbolisieren, dass der Spieler sich in der Nähe eines Gegner befindet. Das Musikstück trägt in dem Fall die Information der Bedrohung durch einen Gegner.

Wieso ein adaptiver Soundtrack eine größere Wirkung auf den Spieler hat, hat mehrere Gründe:

In emotionalen Momenten ist die menschliche Wahrnehmung empfindlicher auf die Umgebung, zu welcher auch die auditive Ebene gehört. Wenn z.B. also im Spiel gerade ein intensivere Herausforderung vom Spieler gemeistert wurde, erwartet der Spieler einen Moment der Erleichterung. Da der Spieler in solchen Momenten besonders auf die klangliche und visuelle Umgebung achtet, muss die Musik auch als passend empfunden werden.

Als weiteren Grund nennt er die willentliche Aussetzung der Ungläubigkeit. Diese ist notwendig um fiktive Videospiele als glaubwürdig und logisch zu sehen bzw. zu akzeptieren. Ein Soundtrack, der für die Umstände im Spiel nicht passend wäre, würde die willentliche Aussetzung der Ungläubigkeit hindern und das Spiel unglaubwürdig wirken lassen. Ein Soundtrack der hingegen adaptiv ist und zu jeder Situation als passend empfunden wird, erhöht stattdessen die Glaubwürdigkeit der Spiels und wird als Teil der Spielwelt angenommen. [2]

Was als passend und glaubwürdig empfunden wird, ist abhängig von der Erwartungshaltung des Spielers, die sich wiederum aus subjektiven Präferenzen bildet [5]. Dazu kommt auch noch, dass der Grad der Immersion des Spiels eine Rolle spielt. Immersion bezeichnet in dem Fall die Involviertheit des Spielers in ein Spiel und die Ausblendung der realen Welt. Dieses Thema werde ich allerdings erst in einem meiner nächsten Blogposts behandeln, da es den Rahmen dieses Artikels sprengen würde.

Methoden zur Umsetzung adaptiver Soundtracks

In den letzten 20 Jahren haben sich einige Standardmethoden zur adaptiven Soundtrack-Gestaltung etabliert. Diese haben unterschiedliche Vor- und Nachteile und werden für verschiedene Funktionen genutzt. Die Umsetzung dieser Methoden geschieht in der Regel über Middleware-Software, wie FMOD oder Wwise. In vereinfachter Form kann sie aber auch direkt in der Spiel-Engine implementiert werden.

Die zwei Grundprinzipien, auf welchen adaptive Soundtracks basieren, heißen Horizontal Resequencing und Vertical Remixing. Zur Beschreibung dieser Methoden, beziehe ich mich auf die Ausführungen Micheal Sweets in seinem Buch “Writing Interactive Music for Video Games: A Composer’s Guide” und auf die Erläuterungen aus dem offiziellen Wwise-Zertifizierungskurs von Audiokinect. [6, 7, 8]

Horizontal Resequencing

Horizontal Resequencing beschreibt eine Methode, bei welchem die Musik von einer Sektion entweder zu einer anderen Sektion oder zurück zum Anfang (Looping) springt. Es ist auch möglich, dass das aktuell laufende Musikstück durch ein komplett anderes Musikstück ersetzt wird. Der Begriff „Horizontal“ beschreibt in dieser Methode den zeitlichen Ablauf einer Komposition, der traditionellerweise auf der horizontalen Achse notiert wird. Für diese Methode gibt es mehrere Möglichkeiten, wie Übergänge realisiert werden. Diese Möglichkeiten umfassen Crossfades, Transitional Scores und Branching Scores.

Crossfading

Bei dieser Art von Übergängen wird der Pegel des aktuell laufenden Musikstücks verringert, während simultan der Pegel des nächsten Musikstücks erhöht wird. Vorteil hierbei ist, dass ein Crossfade jederzeit realisierbar ist und somit schnell auf das Spielgeschehen reagieren kann. Klanglich kann jedoch ein Crossfade in vielen Fällen nicht zufriedenstellend klingen, weil es an das Umschalten von Radiosendern erinnert und nicht sehr musikalisch wirkt.

Um den entgegenzuwirken können die Musikstücke im Tempo aneinander angepasst werden, sodass die Übergänge in sich stimmiger klingen. Bei dem Spiel Witcher 3 haben die Musikstücke, die potentiell oft abwechselnd hintereinander abgespielt werden, wie die Erkundungs- und die Kampfmusik, das selbe Tempo und die selbe Taktart. Zusätzlich ist der überwiegende Teil des Soundtracks in der Tonart D-Moll, was die Übergänge leichter gestaltet.

Transitional Scores

Dieser Übergang verbindet Sektionen oder Musikstücke mithilfe eines musikalischen Elements oder eines Soundeffekts. Bei einer guten Umsetzung eines solchen Übergangs können Musikstücke mit verschiedenen Tempi, Taktarten und Tonarten miteinander verbunden werden und dabei in einen musikalischen Kontext gesetzt werden. Für solche Übergänge eignen sich beispielsweise Crescendi, Glissandi oder auch Soundeffekte wie umgekehrt abgespielte Crashbecken, die aus der elektronischen Tanzmusik oder auch der Popmusik bekannt sind.

Branching Scores

Bei dieser Übergangsmethode gibt es keinen eigentlichen Übergang. Das laufende Musikstück wird vom nächsten Stück ohne einem Crossfade abrupt abgelöst. Damit der Übergang als fließend und passend wahrgenommen wird, geschieht der Wechsel des Musikstücks immer am Ende einer musikalischen Phrase. Bei längeren Phrasen kann das Problem auftreten, dass im Spiel bereits eine neue Handlung einsetzt, während noch die Musik der letzten Handlung läuft, weil die Phrase zu Ende gespielt werden muss. Für diese Methode eignen sich stattdessen kurze musikalische Phrasen, da sie schneller auf das Geschehen reagieren können. Diese Methode kann außerdem genutzt werden, um ein Musikstück in mehrere kleine Segmente aufzuteilen, die in zufälliger Reihenfolge abgespielt werden. Das umgeht die Monotonie, die entsteht, wenn ein Musikstück ständig wiederholt wird und sorgt für eine klangliche Abwechslung.

Vertical Remixing

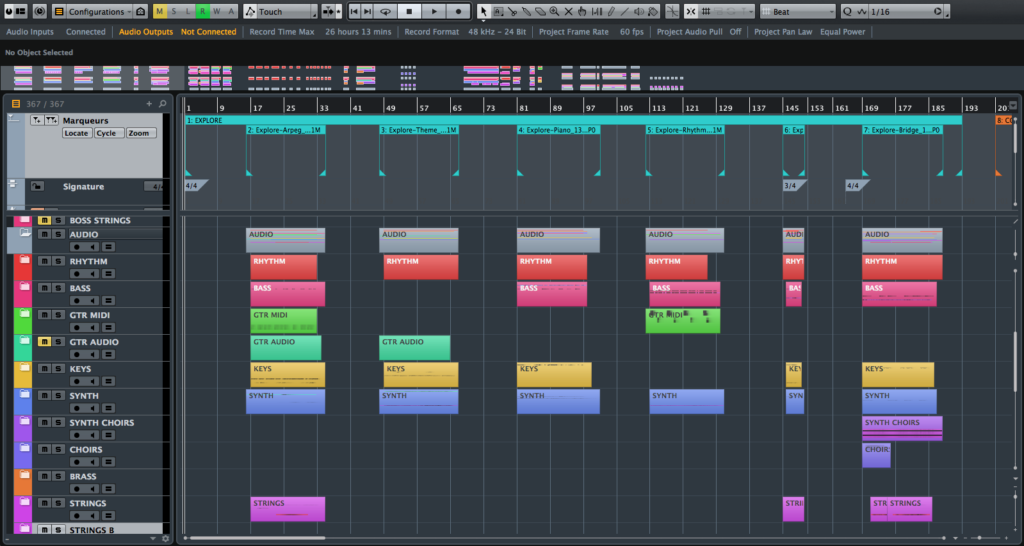

Vertical Remixing basiert auf dem Prinzip des Layerings von Musikstücken. Dabei werden verschiedene Instrumentengruppen in verschiedene Layer aufgeteilt, die je nach Bedarf (Spannungsgrad, Bedrohungsgrad usw.) hinzugefügt werden können. Die Bezeichnung „Vertical“ ist damit begründet, dass Instrumentengruppen in einer Partitur oder in einer Digital Audio Workstation vertikal angeordnet werden. Im Gegensatz zum Horizontal Resequencing arbeitet Vertical Remixing nur mit einem Musikstück, das eine lineare Zeitachse hat. Das hat zur Folge, dass Tonart, Tempo, Taktart und Abfolge vorherbestimmt sind und bei jeder Wiederholung unverändert bleiben. Das sorgt einerseits für eine Kontinuität des Soundtracks, mit welcher die Immersion nicht gestört wird, gleichzeitig ist die Bandbreite an kompositorischen Möglichkeiten hinsichtlich der harmonischen und rhythmischen Abwechslung überschaubar. Grundsätzlich gibt es zwei Möglichkeiten, wie Layer implementiert werden: additiv und individuell kontrolliert.

Additive Layer

Beim additiven Layering wird durchgehend ein Grund-Layer abgespielt und, je nach Bedarf, werden weitere Layer hinzugefügt, sobald Trigger ausgelöst werden. Trigger sind bedingt durch Zustände der Charaktere oder der Spielwelt. Sie beschreiben häufig die Position und die Umgebung, in welcher sich der Charakter des Spielers befindet. Oft gibt es die sogenannte Exploration Music, die das Grund-Layer bildet und die musikalische Untermalung zur Erkundung der Spielwelt darstellt. Je nach Bedarf kommen weitere Layer hinzu. Im Spiel Fallout: New Vegas symbolisiert z.B. die Intensität, die durch das addieren von Layern erzeugt wird, die Nähe zur nächsten Stadt. Je näher der Spieler am Stadtzentrum ist, desto mehr Layer kommen hinzu. In Mass Effect 2 aktiviert das Beginnen eines Kampfes ein Layer bestehend aus Percussion-Instrumenten.

Individuell kontrollierte Layer

Bei dieser Art ist jeder Layer alleinstehend und hat jeweils einen eigenen Trigger. Damit lassen sich verschiedene Situationen im Spiel musikalisch abbilden, die nicht, wie beim additiven Layering aufeinander aufbauen, sondern sich auch gegenseitig ablösen können. Außerdem gibt es auch keinen Grund-Layer, der konstant abgespielt wird. Einige mögliche Layer sehen wie folgt aus: Es gibt einen Layer, der signalisiert, dass der Charakter nur noch wenig Lebenspunkte hat, einen Layer der aktiviert wird, wenn der Spieler geht, und einen Layer, der zu hören ist, wenn der Spieler schwimmt. Dieser Layer wechselt sich mit dem vorherigen ab und kann nicht simultan erklingen, da die beiden Layer zwei verschiedene Zustände darstellen. Allgemein lassen sich mit individuell kontrollierbaren Layern komplexere adaptive Systeme gestalten, die auf verschiedene Zustände reagieren können. Oft wird eine Kombination aus additiven und individuell kontrollierten Layer-Methoden genutzt.

In der Regel werden die Layer mit Lautstärkeautomationen bzw. Fades klanglich ein- und ausgeblendet. Wie lang die Fades dauern, entscheidet das technische Audio-Team oder die Entwickler selbst. Lange Fades fallen weniger auf als kurze oder abrupte Fades. Die Länge variiert nach Michael Sweets Erfahrung zwischen 3000 und 5000 Millisekunden und ist abhängig vom Stil und Tempo der Musik.

Vor- und Nachteile

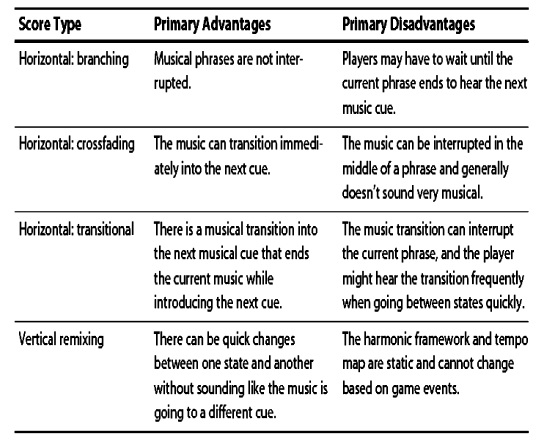

Die verschiedenen Arten von adaptiven Techniken in der Soundtrack-Gestaltung haben jeweils eigene Vor- und Nachteile. Meistens wird eine Kombination aus mehreren Methoden benutzt, die spezielle Einsatzgebiete haben, in welchen die Methoden von ihren Stärken profitieren. In der folgenden Tabelle von Michael Sweet werden zusammenfassend alle Vor- und Nachteile aufgelistet.

Zusammenfassung

Es gibt also verschiedene Möglichkeiten, die zur adaptiven Soundtrack-Gestaltung eingesetzt werden können. Welche Methoden verwendet werden, ist abhängig von der benötigten Funktion bzw. dem zu erzielenden Effekt. Für einen eindrucksvollen adaptiven Soundtrack wird eine gute Kommunikation zwischen dem Komponisten und dem Audio-Team bzw. den Entwicklern des Spiels erfordert. Nur, wenn der Komponist die Vision des Spiels und die Idee hinter den vorgesehenen Anwendungszwecken versteht, kann dieser gezielt einen Soundtrack erstellen, der die verschiedenen Situationen im Spiel und der Spielwelt abdeckt.

Bilderquellen:

[Abbildung 2] S. 162, Michael Sweet, Writing Interactive Music for Video Games: A Composer’s Guide

Literaturquellen:

[1] S. 35 ff., Michael Sweet, Writing Interactive Music for Video Games: A Composer’s Guide

[2] David Vink, https://www.gamecareerguide.com/features/768/student_thesis_adaptive_music_for_.php?print=1

[3] Alex Kanaris-Sotiriou, https://www.polygon-treehouse.com/blog/2018/10/24/what-the-flip-is-non-linear-music#:~:text=Linear%20music%20is%20a%20complete,radio%2C%20or%20any%20film%20score.

[4] Inger Ekman, Psychologically Motivated Techniques for Emotional Sound in Computer Games

[5] S. 9 ff., Tomas Deuschel, Tondramaturgie in Videospielen

Der Einfluss der Ton- und Klanggestaltung auf die Dramaturgie von Videospielen

[6] S. 143 ff., Michael Sweet, Writing Interactive Music for Video Games: A Composer’s Guide